Gran proyecto para comunicarse con otras especies

Secciones

Servicios

Destacamos

Gran proyecto para comunicarse con otras especies

Si pudiéramos hablar con las ballenas, ¿qué les diríamos? Y ellas ¿tendrían algo que comunicarnos? Varios grupos interdisciplinares de científicos han empezado a utilizar la inteligencia artificial (IA) para descifrar el lenguaje de estos mamíferos marinos... y dialogar con ellos.

Prestamos más atención a quienes hablan nuestros idioma. Este es el punto de partida del primer modelo básico de comunicación animal. Lo ha llevado a cabo la organización californiana Earth Species y ya puede clasificar con precisión las llamadas entre las belugas, una especie de rugido que a nuestros oídos suena como un «uop» y que vendría a significar algo así como «estoy aquí». El siguiente paso es aplicarlo a especies tan dispares como los orangutanes, los elefantes y las arañas saltarinas (que hacen vibrar sus patas). El trabajo se centra en los modelos fundacionales, el mismo tipo de computación que impulsa la inteligencia artificial generativa.

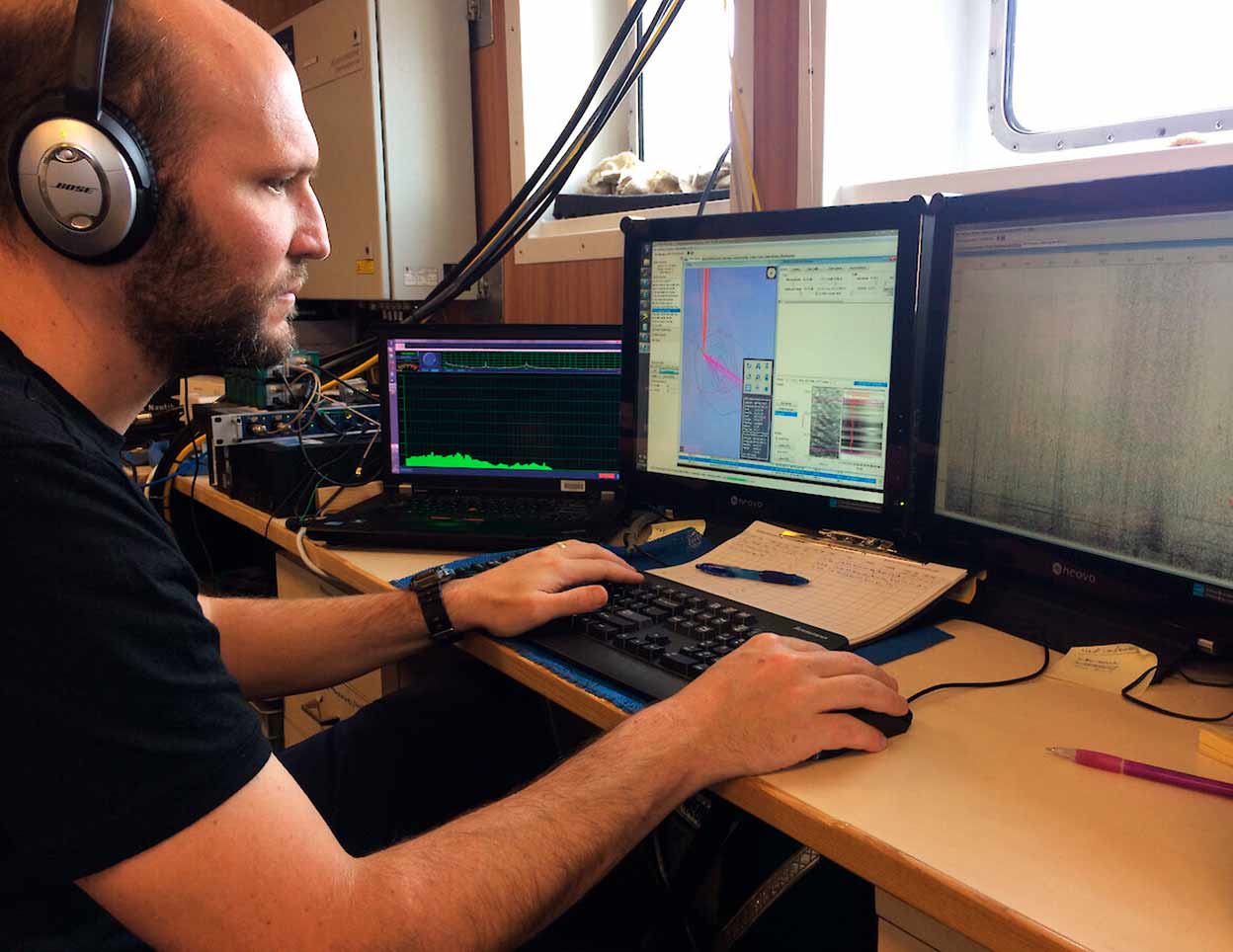

Pero Earth Species no es el único grupo que trabaja en la descodificación de la comunicación animal. El Proyecto CETI (siglas en inglés de Iniciativa para la Traducción de Cetáceos) arrancó en 2022 con el objetivo de comprender el lenguaje de otra especie y, por primera vez, mantener una conversación con ella. Está financiado por la plataforma de conferencias TED y colaboran el Instituto Tecnológico de Massachusetts (MIT) y la National Geographic Society. Agrupa a criptógrafos, expertos en robótica, biólogos marinos y lingüistas que, durante cinco años, desplegarán decenas de dispositivos submarinos de escucha, interpretarán los sonidos e intentarán abrir un canal de comunicación utilizando aprendizaje automático avanzado, procesamiento del lenguaje natural y ciencia de datos. Uno de los asesores fue Roger Payne, el biólogo fallecido a principios de este año, que había grabado en los años sesenta los cantos de las ballenas.

Van a centrar sus esfuerzos en el seguimiento de cachalotes. ¿Por qué los cachalotes? Porque tienen el cerebro más grande del reino animal, seis veces más grande que el nuestro. Y comparten algunas características con los humanos, como el pensamiento consciente, la planificación e incluso la intuición, además de sentimientos de compasión, apego y duelo. Viven en sociedades matriarcales y tienen fuertes vínculos familiares entre varias generaciones. Los cetáceos llevan 30 millones de años surcando los océanos. Los homínidos apenas llevan 6 millones de años en el planeta y el Homo sapiens, 300.000.

Pero, sobre todo, se los ha elegido por una cuestión práctica: los cachalotes se comunican mediante chasquidos. Es un sonido parecido al del código morse y parece fácil de codificar, esto es, de traducir a unos y ceros. Otras ballenas emiten sonidos continuos, más difíciles de introducir en una base de datos. ¿Y por qué no delfines? Porque tienen un repertorio demasiado exuberante: gritos, percusiones, silbidos, gorjeos... Una pesadilla para los informáticos. Además, los cachalotes se sumergen a gran profundidad y se comunican desde grandes distancias, sin que intervenga el lenguaje corporal o las expresiones faciales, que tan importantes son en otras especies, como los primates o incluso los perros, que llevan milenios leyendo nuestra cara.

Coordinan el proyecto la criptógrafa Shafi Goldwasser, directora del Instituto Simons de Teoría de la Computación de la Universidad de California en Berkeley, y David Gruber, biólogo marino de la City University de Nueva York, que jugaban con la idea de traducir esos chasquidos desde 2017. Se unió a ellos el informático Michael Bronstein, profesor del Imperial College de Londres. Pero es ahora cuando han podido empezar a trabajar en serio. Y esto es porque la tecnología de redes neuronales y lingüísticas ha dado un salto asombroso. Un ejemplo son los llamados 'modelos de lenguaje', de los cuales el más avanzado es el GPT-3, desarrollado por la empresa OpenAI. Estos modelos funcionan de manera similar a como los niños aprenden su lengua materna sin necesidad de estudiarla. Les basta con escuchar el idioma que se habla a su alrededor. Es un aprendizaje básicamente estadístico: el niño recuerda que la palabra 'perro' se pronuncia mucho cuando ese peludo animal entra en la habitación.

Los modelos son máquinas de completar. Por ejemplo, reciben el principio de una frase y la completan palabra por palabra, de forma similar a las sugerencias que hacen los smartphones cuando escribimos mensajes de texto. Al procesar enormes cantidades de texto extraído de Internet, los modelos lingüísticos no solo saben qué palabras aparecen juntas con frecuencia, sino que también aprenden las reglas gramaticales. Y crean frases que suenan correctamente, con frecuencia brillantes, y ya son capaces de redactar artículos sobre un tema determinado, resumir textos jurídicos e incluso traducir.

Bronstein, experto en computación, está convencido de que las codas, como se denominan los breves enunciados de los cachalotes, tienen una estructura que se presta a este tipo de análisis. Y conocía a un biólogo llamado Shane Gero que llevaba desde 2005 grabando muchas codas de cachalote cerca de la isla caribeña de Dominica. Bronstein aplicó algunos algoritmos de aprendizaje automático a los datos. «Parecían funcionar muy bien, al menos con tareas sencillas», recuerda. Pero esto no era más que una prueba de concepto. Los algoritmos necesitan mucha más información: millones de codas de ballenas. De momento, solo disponen de unas 100.000, mientras que el entrenamiento de las redes neuronales GPT-3 se llevó a cabo con 175.000 millones de palabras.

La primera fase de la investigación consiste en ampliar la base de datos hasta recopilar unos 4000 millones de palabras, aunque está por definir qué es una palabra en el idioma de los cachalotes. El siguiente paso es desarrollar un modelo que genere enunciados gramaticalmente correctos en ese idioma. Y el último, crear un chatbot interactivo que intente entablar un diálogo con estos cetáceos en libertad.

Un inconveniente de todos los modelos lingüísticos es que no saben nada sobre el contenido de la lengua en la que conversan. Sería irónico que los investigadores crearan un bot que pudiera conversar con fluidez con una ballena, pero luego no pudieran entender ni una palabra de lo que han hablado la IA y el cetáceo. Por eso quieren relacionar los chasquidos con datos sobre los individuos concretos que los emiten: dónde estaban, quién hablaba con quién, cuál era la reacción...

Aprender una lengua desconocida es más fácil si existe algo como la famosa piedra de Rosetta. Esta estela, descubierta en 1799, contiene el mismo texto en tres idiomas y fue la clave para descifrar los jeroglíficos egipcios. Por desgracia, no existe tal cosa para el reino animal. Así que habrá que elaborar un diccionario humano-cachalote y un manual con las reglas gramaticales.

Algunos científicos son escépticos sobre si la recopilación de datos del CETI contendrá algo interesante. El famoso lingüista Steven Pinker tiene pocas esperanzas de que podamos encontrar un contenido y una estructura ricos en las codas de los cachalotes. «Sospecho que no habrá mucho más allá de lo que ya sabemos, es decir, que son llamadas de firma cuya semántica se restringe bastante a quiénes son, quizá también llamadas emocionales y de alerta».

Y todavía hay que desarrollar mucha tecnología. «Queremos escuchar a las ballenas en su propio entorno y con sus propias reglas», explica Gruber, el biólogo. Para conseguirlo, están desarrollando dispositivos blandos no invasivos que sean capaces de soportar velocidades de hasta 50 kilómetros por hora y profundidades de hasta 2000 metros. Son parecidos a las ventosas de los pulpos. «Las ballenas tienen una piel muy suave y la mudan muy rápido, por lo que uno de los retos es diseñar sensores que se fijen con firmeza, pero no tanto como para arrancarles la piel», comenta Michelle Yuen, experta en nanorrobótica. El prototipo puede servir, en el futuro, para otras aplicaciones donde se necesita un contacto delicado, como la cirugía robótica, el tratamiento de quemaduras o el embalaje en almacenes.

Este sensor alberga tres hidrófonos que proporcionan contexto sobre la direccionalidad de la comunicación entre ballenas (quién habla con quién) y que son capaces de registrar altas frecuencias. «Como humanos, podemos oír entre 20 hercios y 20 kilohercios. Aquí estamos grabando a 96 kilohercios o más», explica Daniel Vogt, ingeniero electromecánico. El dispositivo almacena datos durante tres días. Una vez que su memoria está llena o su batería se está agotando, se desprende y sube a la superficie, siempre geolocalizado, hasta que es recogido por los investigadores. El equipo está desarrollando otro tipo de aparatos de 'espionaje', como peces robóticos y drones anfibios.

«El proyecto CETI es una manera de repensar nuestra relación con otras criaturas del planeta –resume Gruber–. Mediante la comprensión de una especie no humana y el poder de la investigación colaborativa, esperamos iniciar un movimiento mundial para conectar más con la naturaleza y aprender de ella». Y si finalmente funciona, ¿qué les diremos a las ballenas? Quizá deberíamos empezar por pedirles perdón por haber contaminado los océanos y haberlas llevado casi a la extinción.

Los científicos todavía no se ponen de acuerdo. Para muchos, el lenguaje sigue siendo un dominio exclusivo de los humanos. El biólogo Konrad Lorenz consideraba que pueden comunicarse, pero que esa comunicación no tiene entidad suficiente para considerarse una lengua. Los perros ladran y comunican una gran variedad de mensajes con sus ladridos: hambre, peligro, alegría, hostilidad... Pero no existe un idioma canino. Otros discrepan, como Karsten Brensing, biólogo marino. «Creo que aún no hemos observado lo suficiente». En cualquier caso, para que exista lenguaje tienen que cumplirse tres condiciones:

1. Se necesita una semántica

La primera es que haya semántica. Ciertas vocalizaciones tienen un significado que no cambia. Se sabe que los arrendajos siberianos tienen un vocabulario de unas 25 llamadas, algunas de las cuales tienen un significado fijo.

2. La gramática como estructura

La segunda es la gramática. ¿Se acuerda de cuando analizaba sintácticamente las oraciones en el colegio? Durante mucho tiempo, los científicos estaban convencidos de que la comunicación animal carecía de cualquier estructura de frases. Pero, en 2016, investigadores japoneses publicaron en Nature Communications un estudio sobre las vocalizaciones de los herrerillos que demostró que estas aves combinan dos llamadas diferentes para advertirse mutuamente cuando se acerca un depredador y, además, lo hacen en un orden determinado.

3. No puede ser innato

La tercera condición es que no se puede llamar lenguaje a las vocalizaciones de una especie si son innatas. Lorenz creía que los animales nacían con un repertorio de expresiones. «Pero no son comparables a nuestro lenguaje hablado, sino más bien a acciones como bostezar, arrugar el entrecejo o sonreír, que no es necesario aprender», escribió Lorenz.