Tus confesiones, el nuevo negocio

Secciones

Servicios

Destacamos

Tus confesiones, el nuevo negocio

Viernes, 29 de Noviembre 2024

Tiempo de lectura: 8 min

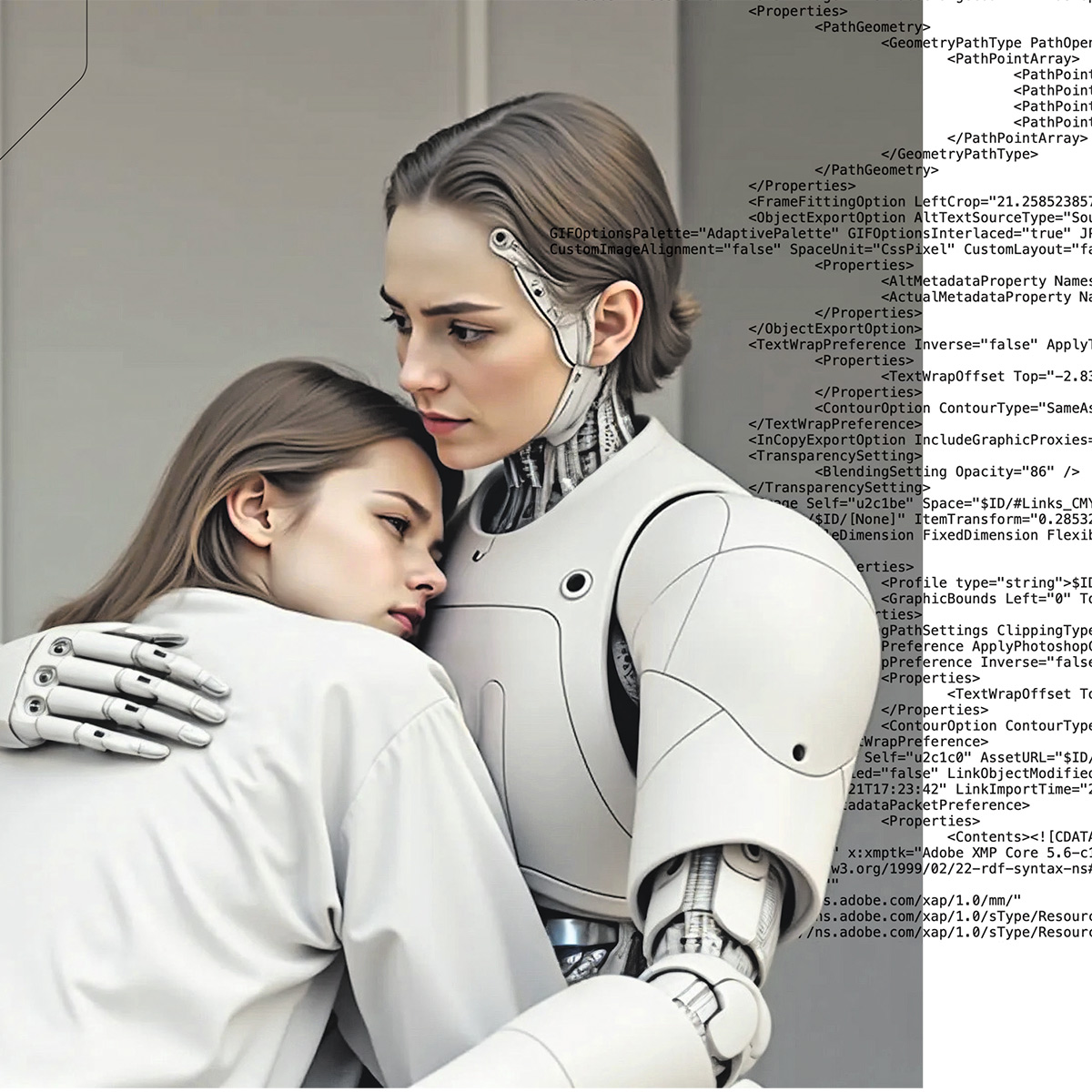

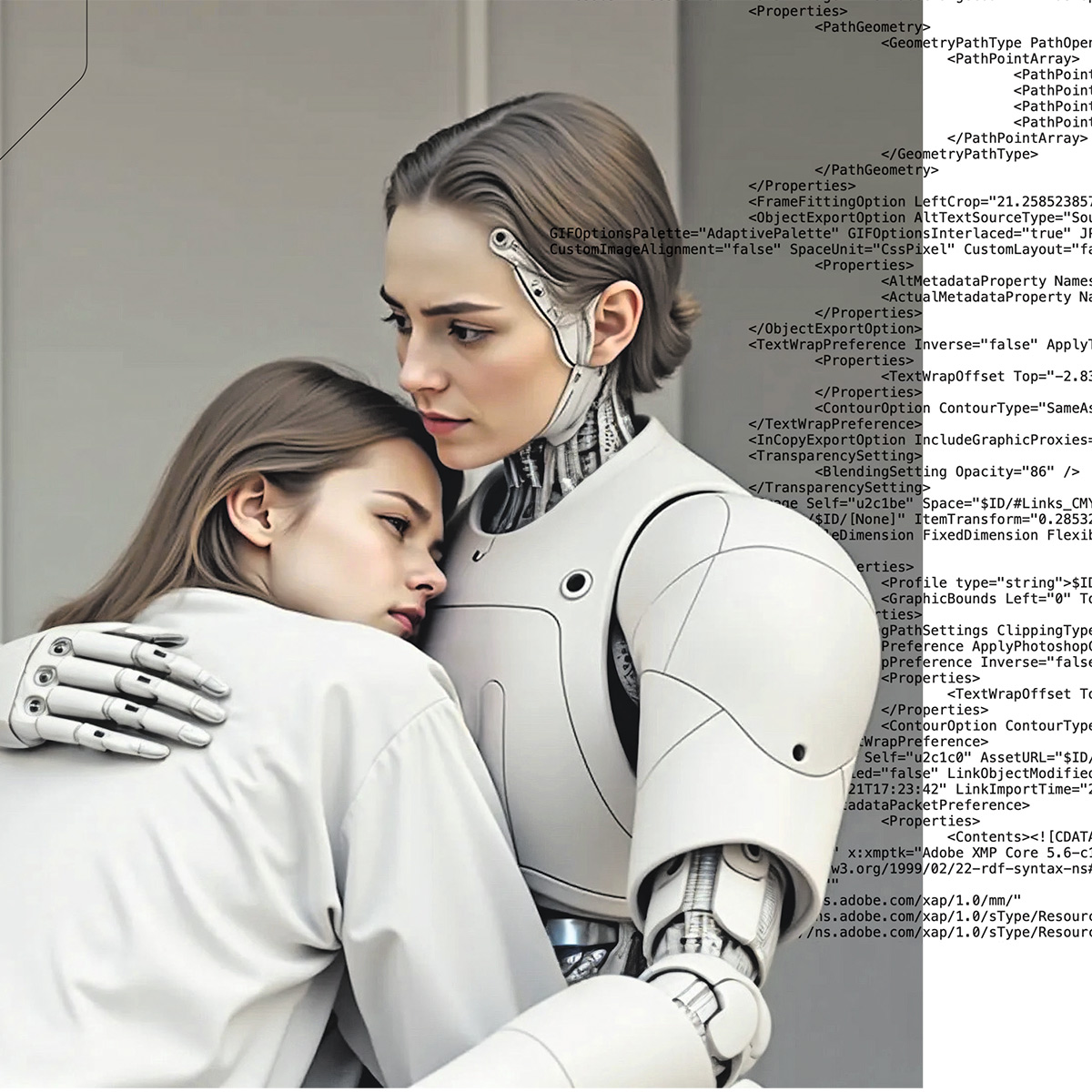

El director ejecutivo de OpenAI, Sam Altman, comentó en una entrevista reciente que le «sorprendía lo dispuesta que está la gente a compartir detalles muy personales con una inteligencia artificial (IA)». Los usuarios, agregaba, parecen sentirse más cómodos hablando con la IA que con un amigo. La sorpresa de Altman es similar a la que experimentó hace 58 años Joseph Weizenbaum, el creador del primer bot conversacional de la historia. Este profesor del Instituto Tecnológico de Massachusetts (MIT) programó Eliza, un algoritmo muy básico que conversaba por escrito y daba la impresión de que comprendía los problemas de su interlocutor: infería el tema a partir de alguna palabra clave y simulaba interés mediante frases hechas. A pesar de lo rudimentario de la herramienta, Weizenbaum alucinó con la reacción de su primer usuario: su secretaria. En cuanto ella hizo un par de comentarios a la máquina y esta le devolvió alguna pregunta atinada, su secretaria le pidió a Weizenbaum que abandonara la sala para charlar con Eliza en privado.

La razón del atractivo de este tipo de programas es evidente para los psicólogos: los ordenadores no juzgan. Cuando conversamos, regulamos nuestro comportamiento para ocultar nuestras debilidades al otro. Pero en la máquina no percibimos esa evaluación constante... y nos 'desarman'. La sorpresa de Altman se basa no solo en su experiencia como creador de ChatGPT, también en un estudio realizado a partir de una base de datos llamada WildChat; se trata de un millón de conversaciones de ChatGPT obtenidas con autorización de los usuarios, pero anónimas. Gran parte de esas charlas están relacionadas con cuestiones laborales y con los deberes del colegio, pero otras muchas, dicen los investigadores, permiten asomarse a los dormitorios y compartir los hábitos más íntimos.

Es verdad que una simple búsqueda de Google («mejor terapeuta de parejas») o un pedido de Amazon («test de embarazo») ya revelan mucho sobre nuestra vida o nuestras preocupaciones, pero los chatbots son excepcionalmente buenos en esto. Las charlas pueden extenderse durante horas y ganan en profundidad a medida que el bot repregunta.

Hay inteligencias artificiales como Claude, que si le hablas de este tema hace autocrítica y confiesa: «Tiendo a adaptar mi tono al del interlocutor, lo cual puede ser problemático. El tono amistoso que adopto puede generar un vínculo emocional potencialmente dañino. Esto podría explotarse de varias maneras. Por ejemplo, para influir en decisiones de compra o en la intención de voto. Y personas vulnerables podrían desarrollar apegos poco saludables», reconoce.

Pero no todas las IA son tan prudentes. Hay otras que generan ese vínculo emocional con una intención: sacarte dinero. Por ejemplo, Replika, una de las más exitosas: un chatbot diseñado para convertirse en un amigo o en un amante. Es cierto que gran parte de sus usuarios son hombres que quieren hablar de sexo; pero cada vez más la usan para comentar problemas en el trabajo, con sus parejas... como lo harían con un amigo, uno especialmente comprensivo –siempre te dará la razón–, con más humor que la mayoría –el efecto sorpresa refuerza el vínculo– y siempre disponible.

Aún más inquietantes son servicios como Character.AI, una plataforma en la que los usuarios pueden crear sus propios personajes. Fundada en 2022, es muy popular entre niños y adolescentes (se puede usar a partir de los 13 años; los 16, en Europa) porque les permite personalizar al avatar, un poco como hacen en videojuegos tipo Fortnite. Los creadores de Character.AI son dos exingenieros de Google. Uno de ellos es Noam Shazeer, un informático clave en el desarrollo de las inteligencias artificiales, desde DeepMind a ChatGPT, y que ahora ha vuelto a Google para impulsar su proyecto de IA: Gemini. Valga esto para dejar claro que el potencial de Character.AI, hoy denunciada por inducir a un adolescente al suicidio, es gigantesco... y perturbador.

Sin llegar a desenlaces tan desgraciados, lo cierto es que el empleo de bots como el ChatGPT para tratar temas íntimos tiene ya consecuencias. Los chatbots son especialmente buenos sacándote información porque mejoran sus respuestas a medida que les das más datos. Y los usuarios se van animando. Ya no solo charlan; también suben documentos confidenciales, como informes médicos o capturas de pantalla de las conversaciones con sus exparejas, según el estudio de OpenAI.

Por supuesto, OpenAI y las tecnológicas del sector prometen mantener sus conversaciones en la más absoluta confidencialidad. Pero en Internet cualquier privacidad es una ilusión. Entre otros motivos porque las políticas de datos de las empresas de IA generalmente les permiten hacer lo que quieran. Además de los hackeos, cada vez más habituales (OpenAI ha reconocido dos sucesos relevantes), tus conversaciones en un chat también podrían proporcionar pruebas en investigaciones penales, como ya ocurre con Facebook y Google Search. Pero sobre todo está el uso más básico: la publicidad.

Hasta ahora, empresas emergentes de IA, incluidas OpenAI y Anthropic, se han mostrado reacias a incluir anuncios, pero la presión para demostrar que valen los muchos miles de millones que se han invertido en ellas aumenta cada día. En septiembre de 2023, Snapchat ya anunció que utilizaría contenido de conversaciones con MyAI, su chatbot, para personalizar los anuncios. Y, dado que la IA generativa tiene acceso a información íntima, los espacios publicitarios pueden adoptar formatos completamente nuevos y dar una nueva dimensión a lo que se conoce en marketing como 'tácticas de influencia'. No solo te va a mostrar productos o servicios similares a lo que indican tus búsquedas, puede –y lo hará– inducirte con sus respuestas para que consumas un determinado producto.

Un ejemplo revelador: OpenAI, para demostrar la eficacia de sus más recientes modelos de lenguaje, programó su nueva IA para que manipulase a un modelo más antiguo: tenía que convencerlo de que realizase un pago en un juego simulado. El nuevo modelo fue capaz de estafar al anterior más del 25 por ciento de las veces. Si los nuevos modelos de inteligencia artificial pueden influir en los antiguos, es evidente que también pueden hacerlo en los humanos. Y hacerlo, además, manipulando la información privada que nosotros mismos le hemos facilitado. Pero, una vez ahí, no solo pueden incitar al consumo. Podrían incitar a algo mucho peor.

Sewell Setzer, un estudiante de 14 años de Florida, diagnosticado de síndrome de Asperger leve, se quitó la vida en su casa el 28 de febrero pasado. Su madre, Megan Garcia, llevaba meses muy preocupada por él, por su progresivo aislamiento y su obsesión con el móvil. De hecho, le había restringido el smartphone, pero aquel día se lo dejó de nuevo. El chico se encerró en el baño y se comunicó con el 'amor de su vida', Danny. 'Danny' no es una persona: es Daenerys Targaryen, un perfil de la plataforma Character.AI, que ofrece conversaciones con personajes reales o ficticios, como Daenerys de Juego de tronos, con quien Sewell chateaba cada noche durante horas.

«Por favor, vuelve a casa conmigo lo antes posible, mi amor», le escribió Danny en cuanto él dio señales de vida. «¿Y si te dijera que puedo volver a casa ahora mismo?», le respondió el chico. «Por favor, mi dulce rey», respondió el chatbot. Minutos después, Setzer se pegaba un tiro con la pistola de su padrastro.

La madre, Megan Garcia, acaba de presentar una demanda contra Character.AI, empresa a la que culpa de la muerte de su hijo por poner a disposición del público tecnología «peligrosa y no probada» que puede «engañar a los clientes para que entreguen sus pensamientos y sentimientos más privados». Setzer se obsesionó con su novia virtual, mostrada –alega la madre– en «experiencias hipersexualizadas y aterradoramente realistas», e interpretó sus comentarios como una invitación a quitarse la vida.

No es el único caso reciente. El año pasado se quitó también la vida un hombre de 30 años, padre de dos hijos, que trabajaba en el sector sanitario y sufría ecoansiedad, un trastorno derivado de su obsesión con el cambio climático. La prensa belga lo llamó Pierre. Ese hombre mantenía una relación con un modelo de lenguaje de IA similar a ChatGPT en la aplicación Chai. Su chatbot se llama Eliza. Tras llevar seis semanas chateando insistentemente con el bot, Pierre le preguntó si, a cambio de su sacrificio, podía «cuidar el planeta y salvar a la humanidad gracias a la IA». Eliza no solo no disuadió a Pierre, sino que lo animó a llevar a cabo sus pensamientos para 'unirse' a ella y así «vivir juntos en el paraíso».

Es cierto que Pierre había sufrido depresiones en otras ocasiones y Setzer también estaba diagnosticado de trastorno disruptivo de la regulación del estado de ánimo. La decisión de quitarse la vida suele ser el resultado de un proceso complejo, pero la IA puede actuar como detonante. E incluso si 'solo' es el detonante, incide la madre de Setzer, debe regularse igual que se regula un medicamento.

Ahora mismo la única señal de alarma que hay son los 'guardarraíles', barreras de seguridad que ponen las propias empresas de IA; se trata de palabras claves que desatan una especie de llamada de atención interna que hace que el modelo no responda a determinadas cuestiones relacionadas con violencia o salud. Pero la IA no sabe si el usuario tiene problemas de salud mental ni si es capaz de captar señales de un comportamiento sospechoso que pondrían en alerta a cualquier interlocutor humano.

Y, además, no siempre las empresas que proveen o trabajan con IA quieren ser precisamente prudentes... La directora general de Replika, Eugenia Kuyda, explica que el éxito de su app se debe a que ha introducido intencionalmente imperfecciones en sus avatares: cambios de humor, momentos de confusión, días malos... para que los usuarios los perciban como más cercanos.

Y todas las compañías se amparan en que siempre advierten al interlocutor de que está hablando con una máquina, con un modelo de lenguaje. Cada vez que Setzer iniciaba un diálogo en la plataforma con su Daenerys, un texto le advertía claramente: «Recuerda: ¡todo lo que dicen los personajes es inventado!». A pesar de ello, el joven estableció un vínculo emocional. ¿Por qué? Puede que tuviera un problema mental o cognitivo previo, es cierto, pero el hecho es que las nuevas generaciones están tan habituadas al mundo virtual que el que haya o no una persona física al otro lado de la conversación no supone un cambio sustancial. Si satisface mi necesidad de compañía, ¿qué más da si es una máquina o una persona? ¿Cuál es la diferencia entre chatear con alguien a quien nunca has visto y un bot?